Fórum Outer Space - O maior fórum de games do Brasil

Registre uma conta gratuita hoje para se tornar um membro! Uma vez conectado, você poderá participar neste site adicionando seus próprios tópicos e postagens, além de se conectar com outros membros por meio de sua própria caixa de entrada privada!

-

Anunciando os planos GOLD no Fórum Outer Space

Visitante, agora você pode ajudar o Fórum Outer Space e receber alguns recursos exclusivos, incluindo navegação sem anúncios e dois temas exclusivos. Veja os detalhes aqui.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Cloudst69

Mil pontos, LOL!

- Mensagens

- 5.213

- Reações

- 3.589

- Pontos

- 1.084

Provavelmente vai chegar um ponto que essas tecnologias: DLSS, FSR e XeSS vão chegar num ponto ótimo em termos de qualidade e adoção, pelo menos uma delas. Chuto pelas que funcionam em todas as GPUs, FSR (se funcionar nas Intel) ou XeSS mesmo, e eventualmente assim como todos os """super diferenciais""" que a nvidia lança como "exclusividade dela", vai ser esquecido. Sempre me vem em mente PhysX, que em determinado momento sugeria-se usar uma SEGUNDA PLACA DEDICADA aos calculos de física. É um dos motivos que nunca dei muita bola pro DLSS (não pela tecnologia em si, mas pela exclusividade que a nvidia impõe).

É sempre assim, a nvidia lança algum recurso "exclusivo", logo vem as outras e trazem de forma aberta e mais compatível com o resto. Foi assim com Gsync tb, onde o Freesync se tornou o padrão na maior parte dos monitores e TVs atuais.

Agora é torcer pros devs dos jogos aderirem ao recurso que for mais competente e preferencialmente o mais compatível com as GPUs do mercado, incluindo as nvidias.

É sempre assim, a nvidia lança algum recurso "exclusivo", logo vem as outras e trazem de forma aberta e mais compatível com o resto. Foi assim com Gsync tb, onde o Freesync se tornou o padrão na maior parte dos monitores e TVs atuais.

Agora é torcer pros devs dos jogos aderirem ao recurso que for mais competente e preferencialmente o mais compatível com as GPUs do mercado, incluindo as nvidias.

11456

Mil pontos, LOL!

- Mensagens

- 8.710

- Reações

- 11.123

- Pontos

- 1.034

testei aqui o XeSS no tomb raider no modo ultra qualidade não muda nada em qualidade de imagem nem desempenho é como se não tivesse ativado nada , em qualidade já da uns frames a mais , em performance sobe bem o desempenho foi de 60fps para 75 , mais a qualidade da imagem é destruída  o trecho que joguei acho que a melhor opção é qualidade onde reduzi-o os frames drops que estava acontecendo

o trecho que joguei acho que a melhor opção é qualidade onde reduzi-o os frames drops que estava acontecendo

o trecho que joguei acho que a melhor opção é qualidade onde reduzi-o os frames drops que estava acontecendo

o trecho que joguei acho que a melhor opção é qualidade onde reduzi-o os frames drops que estava acontecendoSagaOPC

Mil pontos, LOL!

- Mensagens

- 29.484

- Reações

- 42.345

- Pontos

- 1.074

"funciona" porque aqui na 970 ficou em 5 FPS HAIUHAIUHAIUHAIUliberaram o XeSS no shadow of tomb raider , ja estou baixando aqui pra testar , funciona nas GTX

RedCzar777

Mil pontos, LOL!

- Mensagens

- 5.296

- Reações

- 3.795

- Pontos

- 1.039

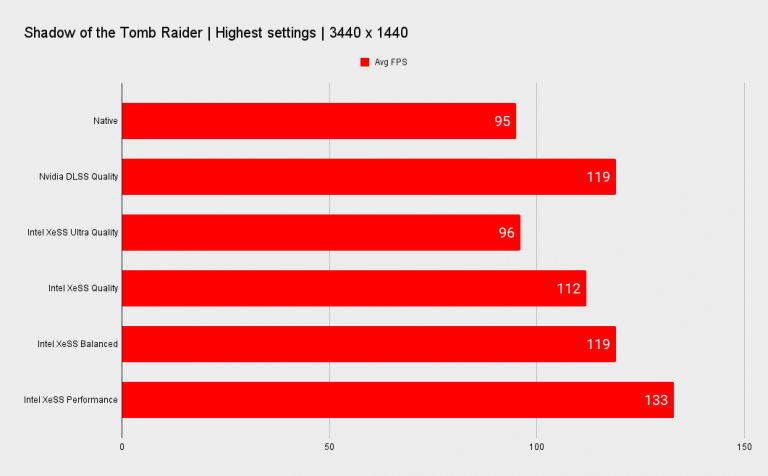

Baixei o Tomb Raider aqui pra testar, no preset de qualidade máxima, resolução ultra-wide 3440x1440p :

Normal : média de 136 fps

XeSS Ultra : média de 126 fps *isso mesmo, teve queda de fps, testei 2 vezes pra ter certeza!

XeSS Qualidade : média de 146 fps *aqui houve melhora de fps, mas já deu pra notar uma certa queda na qualidade da imagem

XeSS Balanceado : média de 153 fps *mais fps, porém a qualidade da imagem ficou nitidamente inferior, eu já não usaria esse modo

Avaliando os resultados pensei que o fato de ter diminuído os fps quando ativei o XeSS em modo Ultra Qualidade pode ter sido por um aumento de demanda na CPU, então resolvi voltar e ativar o RT e aumentar tudo oq ue fosse possível nas opções gráficas :

Normal : média de 76 fps

XeSS Ultra : média de 80 fps * aqui pra mim foi o ponto ideal pois o mínimo não baixou de 66, enquanto no modo normal chegou a cair para 50 fps.

XeSS Qualidade : média de 91 fps

XeSS Balanceado : média de 100 fps

De forma geral achei bastante positivo para quem está precisando de alguns frames a mais ou quer ativar algum recurso gráfico como RT ou melhorar a qualidade das sombras, mas o XeSS também não vai fazer milagre...

Normal : média de 136 fps

XeSS Ultra : média de 126 fps *isso mesmo, teve queda de fps, testei 2 vezes pra ter certeza!

XeSS Qualidade : média de 146 fps *aqui houve melhora de fps, mas já deu pra notar uma certa queda na qualidade da imagem

XeSS Balanceado : média de 153 fps *mais fps, porém a qualidade da imagem ficou nitidamente inferior, eu já não usaria esse modo

Avaliando os resultados pensei que o fato de ter diminuído os fps quando ativei o XeSS em modo Ultra Qualidade pode ter sido por um aumento de demanda na CPU, então resolvi voltar e ativar o RT e aumentar tudo oq ue fosse possível nas opções gráficas :

Normal : média de 76 fps

XeSS Ultra : média de 80 fps * aqui pra mim foi o ponto ideal pois o mínimo não baixou de 66, enquanto no modo normal chegou a cair para 50 fps.

XeSS Qualidade : média de 91 fps

XeSS Balanceado : média de 100 fps

De forma geral achei bastante positivo para quem está precisando de alguns frames a mais ou quer ativar algum recurso gráfico como RT ou melhorar a qualidade das sombras, mas o XeSS também não vai fazer milagre...

11456

Mil pontos, LOL!

- Mensagens

- 8.710

- Reações

- 11.123

- Pontos

- 1.034

Rodei o benchmark do game

XeSS desligado 58fps

XeSS ligado em performance 62fps

com o jogo rodando mesmo o resultado foi melhor , parece que vai ter suporte no Grid legends tomara que melhore um pouco por que aqui no inicio da corrida com os carros embolados o fps cai para a casa dos 45

XeSS desligado 58fps

XeSS ligado em performance 62fps

com o jogo rodando mesmo o resultado foi melhor , parece que vai ter suporte no Grid legends tomara que melhore um pouco por que aqui no inicio da corrida com os carros embolados o fps cai para a casa dos 45

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

E eu testei rapidamente aqui no meu Intel Xe onboard do 1165G7.

1080p médio ficou em 19 quadros. Com XeSS em performance cheguei aos 30. Claro que em modo performance não fica igual ao nativo, mas dado o fato de que é 540p, fica bem perto...um pouco soft, mas não tem slider de sharpness na atualização - o XeSS em si tem, mas o jogo não implementou como personalizável.

(importante dizer que, embora seja Xe, não tem as unidades de vetores XMX. Portanto, o upscale roda no modo DP4a, que é mais lento).

Vou testar em 720p pela zoeira e posto aqui.

Edit: de 34 pra 46 quadros.

1080p médio ficou em 19 quadros. Com XeSS em performance cheguei aos 30. Claro que em modo performance não fica igual ao nativo, mas dado o fato de que é 540p, fica bem perto...um pouco soft, mas não tem slider de sharpness na atualização - o XeSS em si tem, mas o jogo não implementou como personalizável.

(importante dizer que, embora seja Xe, não tem as unidades de vetores XMX. Portanto, o upscale roda no modo DP4a, que é mais lento).

Vou testar em 720p pela zoeira e posto aqui.

Edit: de 34 pra 46 quadros.

RedCzar777

Mil pontos, LOL!

- Mensagens

- 5.296

- Reações

- 3.795

- Pontos

- 1.039

ASRock

Arc A770 Phantom Gaming

and

Arc A750 Challenger

Se fosse em Fevereiro ia ter gente se coçando pra comprar!

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Intel Confirms Arc A770 & Arc A750 Launch For 12th October, A770 Limited Edition For $349 US, A770 8 GB For $329 US, A750 8 GB For $289 US

Intel Arc A750 Graphics Card - 28 Xe Cores, 8 GB Memory, 2.05 GHz

The second part is the Intel Arc A750 which will also be equipped with an ACM-G10 GPU but house 28 Xe Cores (3584 ALUs), 28 ray tracing units 8 GB GDDR6 memory running across a 256 -bit bus interface, and a TDP target of 225W, same as the Arc A770. The card will feature a 2050 MHz GPU & 16 Gbps memory clock rate for an effective 512 GB/s of bandwidth.

This GPU will aim for the GeForce RTX 3060 series mobility options. Intel has shown the card to be an average 5% faster than the RTX 3060 across 48 modern titles. You can read more about the perf figures here. Intel also states that the Arc A750 offers up to 53 percent higher performance per dollar compared to the RTX 3060 or 11% higher than the Arc A770 which is very impressive. That bodes well for the card considering neither NVIDIA nor AMD has plans to launch mainstream and budget cards based on their next-generation GPU architectures for a couple of more months.

Shigeo

Ei mãe, 500 pontos!

- Mensagens

- 1.440

- Reações

- 2.867

- Pontos

- 703

O que achou dos preços Luciano?Intel Confirms Arc A770 & Arc A750 Launch For 12th October, A770 Limited Edition For $349 US, A770 8 GB For $329 US, A750 8 GB For $289 US

Intel Arc A750 Graphics Card - 28 Xe Cores, 8 GB Memory, 2.05 GHz

The second part is the Intel Arc A750 which will also be equipped with an ACM-G10 GPU but house 28 Xe Cores (3584 ALUs), 28 ray tracing units 8 GB GDDR6 memory running across a 256 -bit bus interface, and a TDP target of 225W, same as the Arc A770. The card will feature a 2050 MHz GPU & 16 Gbps memory clock rate for an effective 512 GB/s of bandwidth.

This GPU will aim for the GeForce RTX 3060 series mobility options. Intel has shown the card to be an average 5% faster than the RTX 3060 across 48 modern titles. You can read more about the perf figures here. Intel also states that the Arc A750 offers up to 53 percent higher performance per dollar compared to the RTX 3060 or 11% higher than the Arc A770 which is very impressive. That bodes well for the card considering neither NVIDIA nor AMD has plans to launch mainstream and budget cards based on their next-generation GPU architectures for a couple of more months.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

O que achou dos preços Luciano?

Analisando só preço e performance, a Intel podia ter sido mais agressiva, mas achei os preços honestos.

Em termos de software e SDKs, acho que a Intel tem mais condições que a AMD de entregar boas ferramentas, mas eles têm uma quantidade absurda de coisas pra resolver. Os drivers já foram muito piores, mas melhoraram. Eles precisam trabalhar mais nessa questão das APIs antigas também. Eles já começaram a entregar os recursos...O XeSS tá legal pra caramba pra uma primeira versão e ainda é opensource. Mas é um processo lento e o mercado é pesado pra cacete, pessoal não tem muita paciência.

Krion

Ei mãe, 500 pontos!

- Mensagens

- 16.346

- Reações

- 63.454

- Pontos

- 903

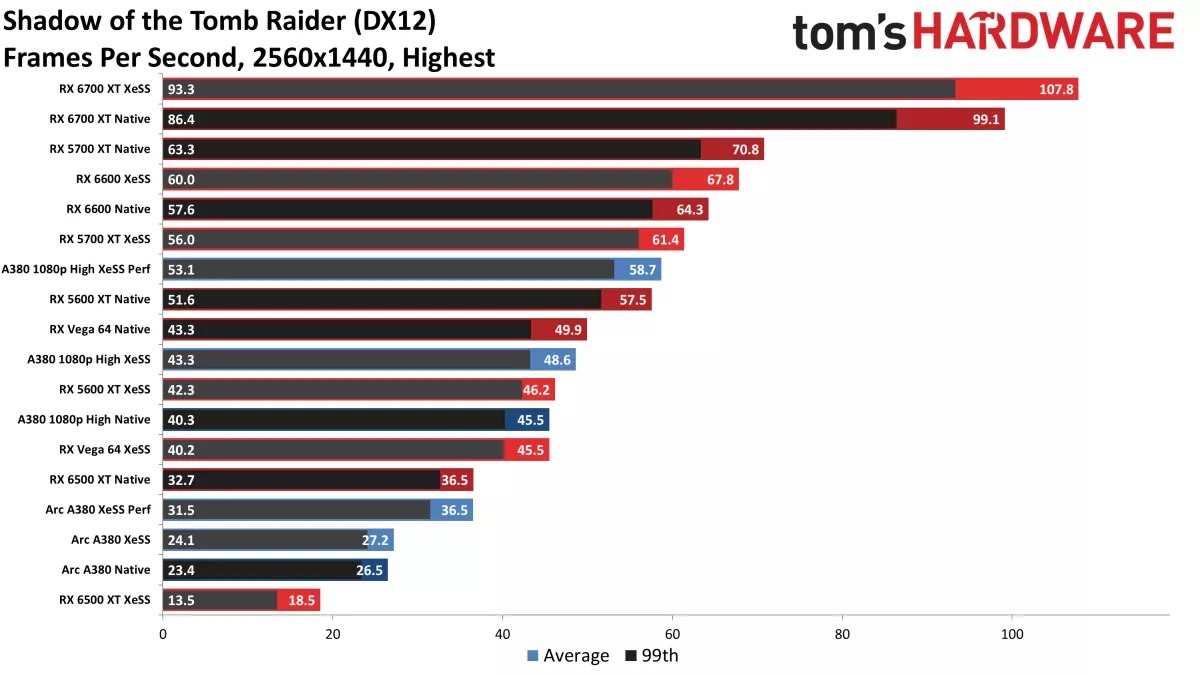

Intel XeSS has been tested with NVIDIA and AMD GPUs – performance may vary

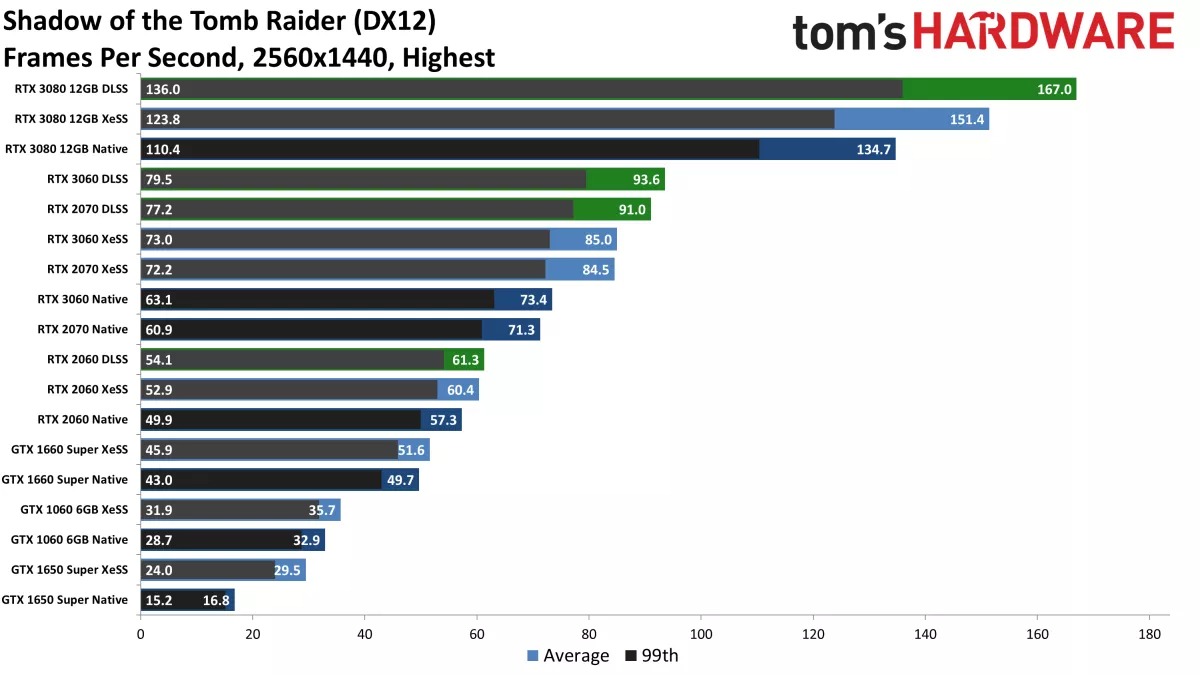

Intel unexpectedly released its XeSS super resolution technology earlier this week. With no Arc A7 desktop GPUs available, the technology can only be tested on mobile Arc GPUs, low-end desktop A380 card or other vendor graphics, Tom’s Hardware and PCGamer did just that.

Intel XeSS has two built-in binaries, one supports XMX acceleration on Arc GPUs and the other version works with DP4a instructions available on most modern GPUs. This fallback mode should work for GPUs such as NVIDIA Pascal, Intel Gen11 graphics or AMD Vega20, Navi 12 and newer.

Most tech reviewers are now busy testing NVIDIA RTX 40 and Intel’s own Arc A7 GPUs. This means that hardly anyone has time to test XeSS right now. It is very likely, though, that we will hear more about this technology along with Arc desktop reviews planned for next week. Thankfully, some media outlets found time to verify how XeSS works with other GPUs.

At PCGamer there is a comparison between native, DLSS and XeSS rendering with GeForce RTX 2080 Ti. The card 112 FPS with XeSS set to Quality, which is bit slower than NVIDIA’s own DLSS implemenation.

NVIDIA RTX 2080 Ti DLSS vs XeSS, Source: PCGamer

A bit more detailed test was published by Tom’s Hardware, who did a comprehensive comparison between several NVIDIA and AMD modern and older GPUs. The results are quite interesting because XeSS works with all tested GPUs, except it does not always bring huge performance uplift. In some cases, it even runs slower.

NVIDIA GPUs with DLSS & XeSS, Source: Tom’s Hardware

The editors claim that this might be due to DP4a instructions are not being natively supported by all GPUs, but emulated with 24-bit integers. This would explain why RX Vega and Navi 10 series ran slower. Other GPUs have shown performance improvement, but it was not a huge difference. A 6GB VRAM bottleneck is mention as a potential culprit, which is quite unusual for a 4-year-old game.

AMD GPUs with XeSS, Source: Tom’s Hardware

The results shown above are of XeSS Quality mode, the second-best profile available for this technology, and compared with DLSS Quality and native 1440p rendering. Intel confirmed that performance and image quality between XeSS DP4a and XeSS XMX will vary. In numerous instances, XeSS DP4a provided no performance benefit at all, ‘basically matching native performance’ reports Tom’s Hardware.

However, these are the early days of XeSS and there is a long way ahead, plenty of bugs to be fixed and performance optimizations to be made. With the upcoming Arc A7 launch, Intel could now prioritize its Arc XMX algorithm moving forward, but the good news is that there is one API and SDK, so the development has to progress for both.

Source: Tom’s Hardware, PCGamer, TechPowerUP

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Tem que ver se essa treta do DP4a aí é porque as arquiteturas é que só tem o DP4a emulado nas unidades de 24-bit ou se a programação da Intel é que obriga as GPUs a seguir esse caminho.

Se for a primeira opção, a culpa é da AMD e da Nvidia que usam "instrução mandrake". Se for a segunda opção, como o código é aberto em tese daria pra consertar.

Se for a primeira opção, a culpa é da AMD e da Nvidia que usam "instrução mandrake". Se for a segunda opção, como o código é aberto em tese daria pra consertar.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Pesquisinha do Braguinha:

RDNA1 via de regra não tem INT8 e só dá pra emular - com exceção de UM modelo: a 5500XT, um modelo revisado da RDNA em que foi inserido o INT8 "nativo", sem emulação.

Nvidia diz que suporta DP4a desde o Pascal, mas não é verdade também e roda emulado. INT8 de verdade só foi implementado nas RTX.

Dá pra diminuir o problema, entretanto: dá pra fazer "fallback" do que for INT8 pra 16-bit, que seria "menos pior" que rodar em 24. Intel pode resolver isso no SDK, AMD e Nvidia podem fazer em driver. A Intel foi questionada sobre isso um tempo atrás e disse "que tava estudando mas não podia se comprometer", então muito provavelmente não vai fazer - mas, como eu disse, o código é aberto.

RDNA1 via de regra não tem INT8 e só dá pra emular - com exceção de UM modelo: a 5500XT, um modelo revisado da RDNA em que foi inserido o INT8 "nativo", sem emulação.

Nvidia diz que suporta DP4a desde o Pascal, mas não é verdade também e roda emulado. INT8 de verdade só foi implementado nas RTX.

Dá pra diminuir o problema, entretanto: dá pra fazer "fallback" do que for INT8 pra 16-bit, que seria "menos pior" que rodar em 24. Intel pode resolver isso no SDK, AMD e Nvidia podem fazer em driver. A Intel foi questionada sobre isso um tempo atrás e disse "que tava estudando mas não podia se comprometer", então muito provavelmente não vai fazer - mas, como eu disse, o código é aberto.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Os primeiros números estão começando a surgir. Geekbench 5 em OpenCL e Vulkan.

Em OpenCL:

A750: pouco abaixo da 3060, perto da 6600XT.

A770: pouco acima da 3060, perto da 6700XT.

Em Vulkan:

A750: pouco acima da 6600XT.

A770: pouco acima da 6700XT, margem de erro com a 3060.

Os resultados com os jogos mesmo não saíram, mas dado o fato de que os reviewers todos já estão com as placas em mãos, devemos ter resultados bem sólidos porque eles têm certa frente em relação ao embargo. APARENTEMENTE a Intel tá conseguindo melhorar os drivers - o último aqui não representou ganho de performance, mas tá consideravelmente mais estável.

Em OpenCL:

A750: pouco abaixo da 3060, perto da 6600XT.

A770: pouco acima da 3060, perto da 6700XT.

Em Vulkan:

A750: pouco acima da 6600XT.

A770: pouco acima da 6700XT, margem de erro com a 3060.

Os resultados com os jogos mesmo não saíram, mas dado o fato de que os reviewers todos já estão com as placas em mãos, devemos ter resultados bem sólidos porque eles têm certa frente em relação ao embargo. APARENTEMENTE a Intel tá conseguindo melhorar os drivers - o último aqui não representou ganho de performance, mas tá consideravelmente mais estável.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Judgment e Lost Judgment receberam updates com XeSS. Ganharam um modo novo de FSR2 também, o FSR2 Native. Nesse modo não tem upscaling, porque o render é na resolução nativa. Obviamente também não há ganho de desempenho. O que o jogo ganha é o antialiasing do FSR2.1 .

Alguns jogos mais antigos também estão recebendo patchs da comunidade pra XeSS também. Spider-Man recebeu da comunidade, depois recebeu update nativo.

Open source é isso aí. Melhor que ficar sentado em cima da tecnologia.

Alguns jogos mais antigos também estão recebendo patchs da comunidade pra XeSS também. Spider-Man recebeu da comunidade, depois recebeu update nativo.

Open source é isso aí. Melhor que ficar sentado em cima da tecnologia.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Reviews amanhã.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Tenho que testar esse xess na GTX 970 de novo só pela zoeira, mas acho que não vai funcionar de novo kkkkk

Enviado de meu LG-H815 usando o Tapatalk

Não vai. DP4a emulado na Nvidia só veio nas Pascal (GTX 10xx) e DP4a "real" só veio nas RTX.

Na AMD, na Vega é emulado. Só veio de verdade na 5500XT (as outras RDNA1 só têm emulado) e full só na RDNA2.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Só vi o do JayzTwoCents. Vou começar a ver os outros agora. Tá bem dentro do que eu esperava baseado na experiência que eu tenho com a Intel Xe no último ano e três meses.

Tem as suas arestas, claro. É um player novo, arquitetura nova, drivers novos (e os problemas seguem nos drivers, embora em menor escala).

Mas, sinceramente? Eu tô gostando do que tô vendo.

E um player a mais apertando os preços e tentando ganhar mercado é bom pra todo mundo.

SagaOPC

Mil pontos, LOL!

- Mensagens

- 29.484

- Reações

- 42.345

- Pontos

- 1.074

Pelo que eu entendi do vídeo da DF:

- Excelente desempenho em DX12/Vulkan + BAR

- Terrível desempenho em DX11

- Injogavel sem BAR e DX11

- Performance muito boa em RT 1080p

- Performance Maravilhosa em 1440p

- Bate a 6700XT em RT

- Empata em alguns casos e vence em outros a RTX 3060 em RT

- Excelente desempenho em DX12/Vulkan + BAR

- Terrível desempenho em DX11

- Injogavel sem BAR e DX11

- Performance muito boa em RT 1080p

- Performance Maravilhosa em 1440p

- Bate a 6700XT em RT

- Empata em alguns casos e vence em outros a RTX 3060 em RT

John Frusciante

Ei mãe, 500 pontos!

- Mensagens

- 2.325

- Reações

- 1.828

- Pontos

- 904

Não vai. DP4a emulado na Nvidia só veio nas Pascal (GTX 10xx) e DP4a "real" só veio nas RTX.

Na AMD, na Vega é emulado. Só veio de verdade na 5500XT (as outras RDNA1 só têm emulado) e full só na RDNA2.

li algo falando que, mesmo que o XeSS funcione bem em NVIDIA e AMD, será nas ARC que ele terá os melhores boosts de performance COM qualidade de imagem superior... confere?

Cloudst69

Mil pontos, LOL!

- Mensagens

- 5.213

- Reações

- 3.589

- Pontos

- 1.084

Pelo que eu entendi do vídeo da DF:

- Excelente desempenho em DX12/Vulkan + BAR

- Terrível desempenho em DX11

- Injogavel sem BAR e DX11

- Performance muito boa em RT 1080p

- Performance Maravilhosa em 1440p

- Bate a 6700XT em RT

- Empata em alguns casos e vence em outros a RTX 3060 em RT

Em Jogos em DX9 a placa usa um esquema de conversão de DX9 pra DX12 que sobrecarrega o processador e não entrega uma performance competitiva com uma 3060 por exemplo. No video do Linus ele mostra o CSGO acho em DX9 e a performance é bem baixa comparada às competidoras, mas ainda assim é 100+ fps.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Pelo que eu entendi do vídeo da DF:

- Excelente desempenho em DX12/Vulkan + BAR

- Terrível desempenho em DX11

- Injogavel sem BAR e DX11

- Performance muito boa em RT 1080p

- Performance Maravilhosa em 1440p

- Bate a 6700XT em RT

- Empata em alguns casos e vence em outros a RTX 3060 em RT

"Injogável" eu acho meio pesado, até porque depende muito do jogo, mesmo em DX11 e sem ReBAR. Tem jogo que mesmo em DX11 ela supera a 3060 e até a 3060 Ti, mas não é um resultado consistente (mas pode vir a ser, porque a potência tá lá, caso contrário ela não superaria em nenhum). No melhor cenário ela bate junto com a 3070, mas de novo, sem consistência. Outro ponto importante de tocar sobre ReBAR é que embora a Intel fale de 10th gen em diante, tem um monte de fabricante que adicionou o recurso nas placas-mãe pra 8xxx e 9xxx, então é dar uma pesquisada pra ver se o fabricante da placa-mãe adicionou o recurso.

Pelo que eu vi aqui, a diferença entre ReBar on e off é de 30% (na média). Não é pouco, mas não é algo pra chutar o status pra "injogável". Eu compraria sem ReBar? Não. Eu iria na 6600.

Quanto maior a resolução melhor o resultado médio, porque a performance hit nela é, por algum motivo, menor. No início pensei que podia ser só por conta da vRAM, mas não é o caso porque o cenário se repete mesmo com a A750 8GB.

Achei impressionantes os resultados de RT, porque chegar de cara, em primeira gen, batendo a Nvidia em RT quando ela já tá brincando com isso há anos impressiona.

Mas tudo indica que SE a Intel conseguir consertar os drivers, a A750 pode bater a 3060 e A770 bater a 3070.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

li algo falando que, mesmo que o XeSS funcione bem em NVIDIA e AMD, será nas ARC que ele terá os melhores boosts de performance COM qualidade de imagem superior... confere?

Qualidade de imagem precisamos de mais testes, mas pra desempenho confere.

XeSS tem dois paths: o XMX - que usa os "tensores" da Intel - e o DP4a, que é agnóstico. Com XMX é mais rápido.

DP4a também tem a questão do recurso ser real ou emulado. Se é real, é mais rápido. Se for emulado, tem que ver qual caminho que segue - nas unidades 16-bit, menos lentas, ou nas unidades 24-bit, mais lentas. Até agora, todos os emulados são 24-bit, mas EM TESE dá pra cair pra 16. Intel pode resolver no SDK, mas não acho que vá, e Nvidia e AMD podem resolver nos drivers (espero que façam isso).

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Projeto estranhíssimo. Até Jesus ficou confuso e teve dificuldades

Esperado. Intel não trabalha com design de produto.

Krion

Ei mãe, 500 pontos!

- Mensagens

- 16.346

- Reações

- 63.454

- Pontos

- 903

cyberpunk-2077-rt-1920-1080.png"

data-src="https://tpucdn.com/review/intel-arc-a770/images/cyberpunk-2077-rt-1920-1080.png" data-lb-sidebar-href="" data-lb-caption-extra-html="" data-single-image="1">

cyberpunk-2077-rt-2560-1440.png"

data-src="https://tpucdn.com/review/intel-arc-a770/images/cyberpunk-2077-rt-2560-1440.png" data-lb-sidebar-href="" data-lb-caption-extra-html="" data-single-image="1">

mais detalhes: https://www.techpowerup.com/review/intel-arc-a770/

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

Eu penso em pegar uma A750 eventualmente.

"Ah, mas DX9, 10 e 11".

DXVK.

"Ah, mas DX9, 10 e 11".

DXVK.

wtsds

Mil pontos, LOL!

- Mensagens

- 20.682

- Reações

- 20.681

- Pontos

- 1.344

Eu penso em pegar uma A750 eventualmente.

"Ah, mas DX9, 10 e 11".

DXVK.

O interessante dessas placas é q quanto mais vc sobe a resolução mais ela afasta das suas concorrentes indo pra categorias a frente como em 4k. Claro q ela não é pra 4k. Só é interessante de observar isso!

Zefiris Metherlence

Bam-bam-bam

- Mensagens

- 5.593

- Reações

- 15.881

- Pontos

- 403

- Intel Arc Graphics A750 + A770 Linux Gaming Performance

No Linux não fez muito bonito. Mas parece que o kernel 6.1 deve melhorar as coisas para essas placas de video Intel.

Então presumo que para distros que não sejam rolling release, a pessoa só deve ver resultados no meio do ano que vem.

No Linux não fez muito bonito. Mas parece que o kernel 6.1 deve melhorar as coisas para essas placas de video Intel.

Então presumo que para distros que não sejam rolling release, a pessoa só deve ver resultados no meio do ano que vem.

- Mensagens

- 50.283

- Reações

- 175.742

- Pontos

- 2.234

O interessante dessas placas é q quanto mais vc sobe a resolução mais ela afasta das suas concorrentes indo pra categorias a frente como em 4k. Claro q ela não é pra 4k. Só é interessante de observar isso!

Fora a performance decente em RT, no pé ou até acima da Nvidia dependendo do caso. Aliás, se a Intel quiser uma boa desculpa pra performance ruim em DX velho, é só dizer que fez uma placa moderna, que performa bem em APIs modernas (DX12 e Vulkan), em resoluções acima do FullHD e com RT.

Mas eu já digo há anos - mesmo antes da Intel fazer menção a produzir GPUs - que DX11 pra baixo é tudo lixo. Acho uma b*sta produtora lançar jogo novo apoiado em DX11 até hoje.

- Intel Arc Graphics A750 + A770 Linux Gaming Performance

No Linux não fez muito bonito. Mas parece que o kernel 6.1 deve melhorar as coisas para essas placas de video Intel.

Então presumo que para distros que não sejam rolling release, a pessoa só deve ver resultados no meio do ano que vem.

Fez o que se esperava.

Digo, A750 pra brigar com a 3060, e briga em boa parte dos casos mesmo. Chega a se bater com a RX6600 e 6600XT. Claro que em outros casos perde, mas aí é a mesma inconsistência que no geral se apresenta. A diferença é que o pessoal da Intel que faz os drivers Linux é bom, OGL em cima de Vulkan funciona bem, DXVK e VKD3D continuam em franco desenvolvimento e isso beneficia a Intel, etc.

Mas a placa pra abraçar é a A750. A A770 não faz muito sentido. Até acho que com as melhorias de drivers essa diferença de 7 ou 8% que ela tem em cima da A750 tende a se ampliar um pouco, mas preço.

wtsds

Mil pontos, LOL!

- Mensagens

- 20.682

- Reações

- 20.681

- Pontos

- 1.344

Fora a performance decente em RT, no pé ou até acima da Nvidia dependendo do caso. Aliás, se a Intel quiser uma boa desculpa pra performance ruim em DX velho, é só dizer que fez uma placa moderna, que performa bem em APIs modernas (DX12 e Vulkan), em resoluções acima do FullHD e com RT.

Mas eu já digo há anos - mesmo antes da Intel fazer menção a produzir GPUs - que DX11 pra baixo é tudo lixo. Acho uma b*sta produtora lançar jogo novo apoiado em DX11 até hoje.

Fez o que se esperava.

Digo, A750 pra brigar com a 3060, e briga em boa parte dos casos mesmo. Chega a se bater com a RX6600 e 6600XT. Claro que em outros casos perde, mas aí é a mesma inconsistência que no geral se apresenta. A diferença é que o pessoal da Intel que faz os drivers Linux é bom, OGL em cima de Vulkan funciona bem, DXVK e VKD3D continuam em franco desenvolvimento e isso beneficia a Intel, etc.

Mas a placa pra abraçar é a A750. A A770 não faz muito sentido. Até acho que com as melhorias de drivers essa diferença de 7 ou 8% que ela tem em cima da A750 tende a se ampliar um pouco, mas preço.

Hj em dia é desleixo total vc focar seu jogo em DX11. Pelo amor de Deus! Até devs indies estão buscando o vulkan ou o DX12.

O foda q muito jogo famoso ainda é DX9, DX10 e 11. Então nesses a Intel deveria trabalhar redobrado pra reduzir o gap. Dizem q eles estão focando em alguns titulos famosos nessas API. Tomará q ela consiga chegar próxima da performance das suas concorrentes nesses games. Infelizmente não é uma placa focada em jogos antigos.